Come funziona ChatGPT e i Large Language Models. Spiegato facile

Rilassati.

Con Deep Marketing hai la migliore agenzia veneta secondo IB Awards, credibilità e senior manager con 20 anni di esperienza.

Visibilità garantita su testate nazionali senza l'utilizzo di pubbliredazionali?

Prova la nostra incredibile promozione: se la nostra strategia non riesce a farti ottenere articoli reali dai giornalisti, ti rimborsiamo.

Questo approfondimento è stato scritto da Francesco Galvani, CEO di Deep Marketing, insegnante di branding strategy, divulgatore scientifico e - soprattutto - sviluppatore di reti neurali e sistemi di intelligenza artificiale nel marketing e nella finanza dal 2003. Buona lettura!

Cos'è l'apprendimento automatico

Immaginate il cervello umano, con i suoi miliardi di neuroni interconnessi che comunicano tra loro. Ora immaginate di creare un "cervello artificiale" simile, fatto di software e hardware. Banalizzando, ecco i moderni sistemi di intelligenza artificiale come GPT-4 e ChatGPT.

Invece di neuroni, questi sistemi hanno quelli che si chiamano "nodi". E invece delle sinapsi, hanno "connessioni" matematiche tra i nodi. Proprio come il nostro cervello impara attraverso l'esperienza, anche queste reti neurali artificiali imparano analizzando enormi quantità di dati.

Più dati essi processano, più il sistema diventa "intelligente" e capace di generare testo, rispondere a domande, tradurre lingue e molto altro. È una sorta di apprendimento automatico.

Per capire come funzionano GPT-4 e ChatGPT, dobbiamo prima comprendere cos'è l'"apprendimento automatico". Si tratta di un campo dell'intelligenza artificiale dove i computer imparano ed evolvono attraverso l'esperienza, proprio come gli esseri umani.

Per esempio, supponiamo di voler addestrare un computer a riconoscere gatti e cani nelle immagini. Gli forniamo migliaia di immagini di gatti e cani, ognuna etichettata correttamente ("questo è un gatto", "questo è un cane"). Esaminando questi dati, il sistema impara lentamente a riconoscere modelli e caratteristiche distintive dei gatti e dei cani, fino a quando non è in grado di categorizzare nuove immagini che non ha mai visto prima, ma che condividono con quelle su cui è stato addestrato molti elementi morfologici.

Man mano che riceve più dati e feedback (un processo chiamato "apprendimento supervisionato"), il sistema continua a migliorare la sua precisione. E con abbastanza dati e potenza di calcolo, questi software possono raggiungere e persino superare le prestazioni umane in compiti specifici.

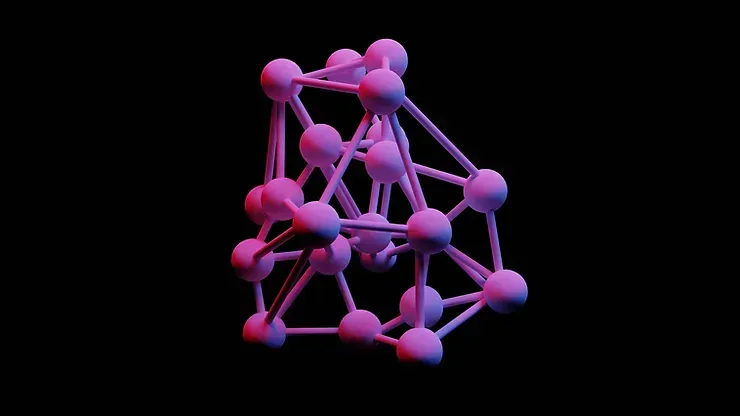

Le reti neurali artificiali

I moderni sistemi di intelligenza artificiale sono basati su reti neurali artificiali, ispirate (anche se in modo molto semplificato e biologicamente non realistico) al cervello umano. Le reti neurali sono composte da nodi interconnessi organizzati in "strati".

In ogni strato ci sono molti neuroni artificiali, i nostri nodi. Gli stati sono generalmente tra loro sovrapposti (anche se ci sono architetture più complicate).

Ogni nodo riceve input da altri nodi, di solito dello strato sottostante, esegue semplici calcoli matematici su tali input e produce un output. Collegando molti nodi in diversi strati, si ottiene una rete in grado di modellare relazioni molto complesse tra gli input e gli output.

Ad esempio, gli input potrebbero essere pixel di immagini di gatti e cani. Man mano che questi dati attraversano la rete neurale artificiale, i modelli vengono estratti e gli output finali identificano l'immagine come "gatto" o "cane".

L'addestramento delle reti neurali

La chiave per costruire reti neurali davvero "intelligenti" è addestrarle con enormi quantità di dati rilevanti, un processo computazionalmente intensivo noto come "apprendimento profondo" (deep learning). Più dati diamo, più il sistema può imparare modelli e regole più sofisticati.

I ricercatori raccolgono set di dati massicci chiamati "corpus" (plurale "corpora") per addestrare i sistemi. Ad esempio, per addestrare GPT-4 e ChatGPT sono stati utilizzati corpora di testo che contengono miliardi di pagine web, libri, articoli e contenuti generati dagli utenti.

I parametri interni della rete neurale vengono graduamente regolati per migliorare le sue prestazioni, riducendo gli errori durante il processo di apprendimento supervisionato di cui abbiamo parlato prima.

I modelli di linguaggio - i Large Language Models

Un tipo particolarmente potente di rete neurale sono i "modelli di linguaggio" (o large language models - LLM), progettati per elaborare e generare testo e dialogo umano. Possono tradurre lingue, rispondere a domande, scrivere testi coerenti e persino generare immagini artificiali basate su descrizioni testuali.

I modelli di linguaggio vengono addestrati su giganteschi corpora di testo in diverse lingue per imparare le complesse regole e relazioni nel linguaggio umano.

Ad esempio, imparano che alcune parole e frasi hanno maggiori probabilità di seguire altre parole e frasi specifiche. Imparano anche la struttura e la grammatica di frasi e paragrafi diversi.

Man mano che il modello viene addestrato su più testo, la sua comprensione del linguaggio diventa più profonda e sofisticata. Può quindi generare testo più naturale e umano, oltre a comprendere meglio il linguaggio umano.

I due modelli all'avanguardia oggi a nostro avviso sono

Claude, sviluppato da Anthropic, e

ChatGPT di OpenAI.

Cos'è GPT-4

GPT-4 è l'ultima versione del modello Generative Pre-trained Transformer sviluppato da OpenAi, un'azienda di AI fondata da nomi famosi, tra cui Elon Musk e Sam Altman.

Come suggerisce il nome, GPT-4 è l'evoluzione di GPT-3 e continua a spingere i confini di ciò che l'IA generativa può fare. È addestrato su un enorme corpus di testo che include libri, articoli, pagine web e molto altro.

GPT sta per "Generative Pre-trained Transformer". Generative significa che può generare nuovo testo coerente. Pre-trained significa che è già stato addestrato su una grande quantità di dati e non richiede ulteriore addestramento per applicazioni specifiche. E Transformer fa riferimento all'architettura computazionale sottostante. Ci arriveremo tra poco.

Quindi in poche parole, GPT-4 è un modello AI massiccio pre-addestrato che può generare testo estremamente realistico e persino immagini artificiali da semplici prompt di testo forniti dagli utenti.

Può tradurre lingue, rispondere a domande, riassumere testi lunghi, correggere errori grammaticali e di battitura, scrivere storie creative e altro ancora. In alcuni compiti di generazione di testo e immagini, si avvicina alle capacità umane.

ChatGPT

ChatGPT è derivato da GPT-4, ma ottimizzato per la chat conversazionale. È stato sviluppato da OpenAI per avere discussioni naturali e umane.

Può rispondere a domande in modo dettagliato, ammettere quando non sa qualcosa, correggere informazioni errate e persino rifiutarsi di fornire contenuti dannosi. Tutto in un formato di chat interattiva.

ChatGPT è addestrato tramite un processo chiamato "apprendimento per rinforzo da feedback umano", dove gli viene insegnato cosa costituisce una risposta di alta qualità attraverso milioni di esempi.

Ciò significa che può mantenere conversazioni più lunghe e approfondite rispetto ai precedenti chatbot. Può persino imparare nuovi concetti man mano che parla con gli utenti, rendendolo più utile nel tempo.

Come funziona l'architettura a Transformer di ChatGPT

In passato, i sistemi di intelligenza artificiale che elaboravano il linguaggio naturale si basavano su approcci tradizionali come le reti neurali ricorrenti. Questi modelli avevano delle limitazioni nel comprendere frasi e contesti lunghi e complessi. Poi, nel 2017, è stato presentato un nuovo tipo rivoluzionario di modello chiamato "transformer".

I transformer hanno introdotto un nuovo approccio basato sui meccanismi di attenzione, che permette loro di analizzare meglio le relazioni tra le parole in una frase. I transformer sono stati un enorme passo avanti e hanno aperto la strada ai moderni grandi modelli linguistici che utilizziamo oggi.

Cos'è l'attenzione e come funziona

Ma cos'è esattamente il "meccanismo di attenzione" che rende i transformer così potenti?

Potete immaginare l'attenzione come uno "sguardo" che il modello linguistico utilizza per focalizzarsi sulle parti più rilevanti del testo. Proprio come facciamo noi esseri umani quando leggiamo, il modello decide a quali parole o frasi prestare attenzione per capire meglio il significato generale. Dal punto di vista tecnico, i meccanismi di attenzione assegnano un "punteggio di attenzione" ad ogni parola nella frase. Le parole con punteggi più alti vengono "prese in considerazione" in modo più approfondito dal modello per estrarne relazioni e significati. Questo approccio è molto più efficace rispetto ai precedenti, perché permette al modello di focalizzarsi veramente sulle parti fondamentali del testo, proprio come noi esseri umani!

In modo piuttosto interessante, la potenza di un sistema LLM (large language model) è legato al contesto di parole in cui i meccanismi di attenzione possono esercitare la loro potenza: più capacità di processare il contesto, più il sistema sembrerà intelligente!

Struttura interna di un modello linguistico

Ora che abbiamo capito in generale i meccanismi di attenzione, diamo un'occhiata più da vicino all'architettura interna di questi modelli linguistici.

Innanzitutto, i dati di testo in ingresso (per esempio una frase) vengono convertiti in vettori numerici attraverso un processo chiamato "embedding" - o "word embeddings". Ogni parola viene trasformata in un vettore di numeri che ne cattura il significato in modo matematico.

Questi vettori vengono poi elaborati attraverso una serie di strati di elaborazione, come abbiamo visto nei capitoli precedenti. Ogni strato applica le operazioni di attenzione e crea rappresentazioni via via più astratte e contestuali del testo in ingresso.

Gli strati finali del modello infine generano un vettore di output che rappresenta l'intera frase e che può essere utilizzato per vari scopi, come la classificazione, la traduzione o la generazione di nuovo testo.

Dove tutto è iniziato

Per esempio, uno dei primi e più famosi modelli linguistici basati sui transformer è BERT (non "BART"), sviluppato da Google nel 2018. BERT ha ottenuto risultati strabilianti in compiti come il completamento di frasi o l'identificazione di relazioni tra parole chiave.

Modelli successivi come GPT-3 o PaLM sono stati addestrati su quantità enormi di dati e contengono miliardi di parametri. Possono generare testi incredibilmente umani e sono persino in grado di svolgere semplici conversazioni.

Che differenza c'è tra le reti neurali e il cervello umano?

Esistono alcune importanti differenze tra le reti neurali artificiali e il cervello umano:

- Il cervello umano è estremamente complesso, con oltre 100 miliardi di neuroni e trilioni di connessioni, per non parlare della complessità dei neurotrasmettitori e delle strutture a supporto. Le reti neurali artificiali sono molto più semplici, con tipicamente solo alcuni strati di neuroni artificiali. Anche GPT-4 non si avvicina nemmeno da distante alla biologia.

- Il cervello umano impara in modo continuo dall'esperienza, mentre le reti neurali devono essere addestrate su grandi set di dati. Una volta addestrate, le reti neurali non continuano ad apprendere.

- Il cervello umano è in grado di svolgere una grande varietà di compiti, dalla visione al linguaggio, alla pianificazione. Le reti neurali sono progettate per compiti specifici come il riconoscimento delle immagini o la generazione di parole. Esistono reti multimodali ma non c'entrano nulla con l'intelligenza generale della mente umana.

- Il cervello umano è tollerante ai guasti e può continuare a funzionare anche se danneggiato. Le reti neurali artificiali sono fragili e possono fallire completamente se i loro parametri vengono alterati.

- Il funzionamento interno del cervello umano rimane in gran parte sconosciuto. Al contrario, i parametri e l'architettura delle reti neurali artificiali sono completamente noti.

Il futuro di GPT-4, ChatGPT e oltre

Quindi, cosa riserva il futuro per questi sistemi di intelligenza artificiale e come potrebbero evolversi?

Innanzitutto, diventeranno molto più potenti. La legge di Moore prevede che la potenza di calcolo dei computer raddoppi all'incirca ogni 1-2 anni. Ciò significa che entro il 2030, i modelli potrebbero avere mille trilioni di parametri o più!

Ciò potrebbe portare a sistemi AI molto più versatili e dalle prestazioni quasi umane in molti compiti diversi. Potrebbero persino superare gli esseri umani in aree specifiche come la generazione di testo e immagini artificiali. Ma l'aumento della potenza computazionale da solo non basta. Saranno necessari nuovi algoritmi e architetture per sfruttare tutta questa potenza extra in modo efficace. Ad esempio, l'architettura Transformer ha già rivoluzionato le prestazioni del linguaggio rispetto ai modelli precedenti.

Un'altra area di miglioramento sarà l'integrazione di più modalità di dati oltre al solo testo, come immagini, audio e video. Ciò consentirà sistemi AI più consapevoli e capaci di comprendere il mondo.

Infine, la chiave sarà garantire che questi sistemi siano davvero sicuri, controllabili ed etici man mano che diventano più potenti.